Jika Anda memiliki environment existing berbasis VMware dengan cloud di AWS, Anda dapat membuat suatu sistem hybrid cloud antara 2 environment tersebut. Anda dapat menghubungkan kedua environment tersebut, baik menggunakan AWS Direct Connect atau menggunakan VPN. Jika kebetulan di environment VMware Anda menggunakan VMware NSX, maka Anda dapat menghubungkan ke AWS menggunakan fitur VPN IPsec di AWS dan NSX. Di artikel ini saya akan menjelaskan cara konfigurasinya.

Category: Virtualization

Konfigurasi Load Balancer VMware NSX dengan SSL-Offload

VMware NSX merupakan software network virtualization dan security platform dari VMware. Salah satu fitur yang ada di NSX adalah load balancer, dan sesuai namanya, dapat digunakan sebagai load balancer atau gateway untuk membagi traffic dari beberapa VM yang ada di environment VMware Anda. Hal ini cukup penting untuk menjaga high availability dari layanan Anda.

Load balancer yang terdapat di NSX memiliki cukup banyak fitur diantaranya :

- Support TCP seperti HTTP, HTTPS, FTP, dan lain-lain.

- Support UDP

- Support beberapa algoritma load balancer : round-robin, least connection, source IP hash, URI

- Support multiple health check : TCP, HTTP, HTTPS termasuk content inspection

- Support connection throttling : max connection dan connections/sec

- Layer 7 manipulation seperti URL block, URL rewrite, content rewrite

- SSL offload / SSL termination

- L4/L7 transparent mode

- Throughput up to 9 Gbps dan concurrent connection up to 1 million

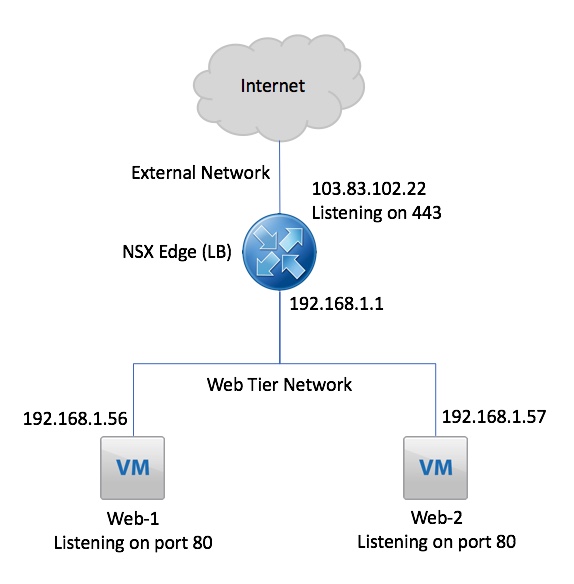

Dari sisi deployment, NSX Edge dapat menggunakan mode one-arm maupun two-arm. Di tutorial kali ini, RouteCloud akan menjelaskan cara konfigurasi load balancer untuk 2 buah VM website dengan SSL-Offload. Dengan SSL-offload, user dapat mengakses website menggunakan https, dan proses enkripsi SSL akan dihandle oleh NSX Edge. Di bawah ini adalah topologi yang akan diimplementasikan :

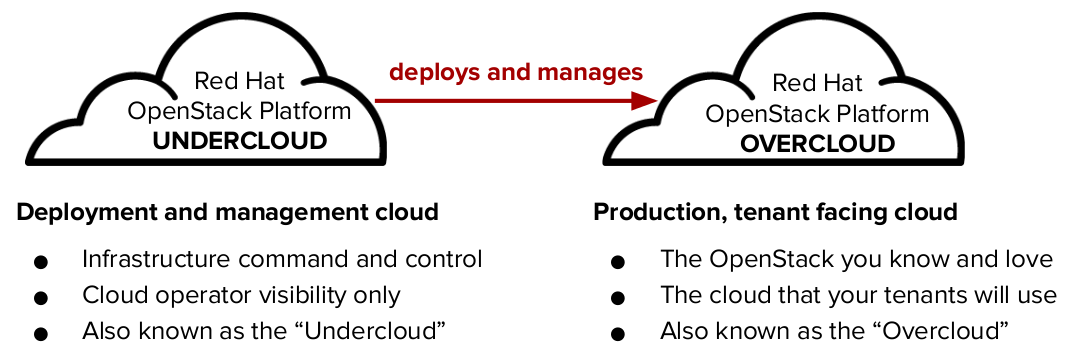

Menambahkan node overcloud pada redhat openstack platform director

menlajutkan tulisan tutorial sebelumnya yaitu Install Redhat Openstack platform , maka selanjutnya kita akan membahas menambahkan node overcloud, untuk definisi overcloud dan komponennya sudah saya jelaskan pada tutorial sebelumnya 🙂

Install Redhat Openstack Platform Director 10

Redhat Openstack Platform Director adalah alat untuk install dan mengelola openstack secara kompleks. openstack director redhat merupakan based on openstack project TripelO (Openstack-On-Openstack). project ini memiliki kelebihan dalam menginstall dan mengoperasikan secara lengkap dari environtment openstack.

Install dan konfigurasi LXD di Ubuntu 16.04

mungkin anda pernah mendengar LXC atau Linux Container, sebuah management container os yang di kembangkan oleh ubuntu. nah LXD adalah “next generation system container manager“. dimana LXD sebenarnya adalah container based OS yang menawarkan user experience yang hampir sama dengan virtual machine. wow cukup menarik bukan? menurut saya sih cukup menarik karena LXD ini juga di pake oleh JUJU dan MAAS untuk deploy openstack. LXD memiliki fitur yang cukup menarik seperti dibawah ini

Mengatasi error “VirtualInterfaceCreateException: Virtual Interface creation failed” pada OpenStack

Jadi ceritanya hari ini tanggal 6 Februari 2018 saya mencoba menginstall openstack ocata multi node, yang saya install diatas CentOS, pada awalnya semua berjalan lancar dimulai provisioning vm ubuntu, kemudian saya mencoba provisioning windows cloud base, muncul error seperti dibawah ini.

|

1 2 3 4 5 6 7 8 9 |

2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [req-906459f9-6985-4a2c-a57b-d48532b4a26c 2d66793ad98943edbd0f787ab6cbebb4 e249291ffdf147c6a93a302e5d78130d - - -] [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] Failed to allocate network(s) 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] Traceback (most recent call last): 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] File "/usr/lib/python2.7/site-packages/nova/compute/manager.py", line 1938, in _build_and_run_instance 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] block_device_info=block_device_info) 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] File "/usr/lib/python2.7/site-packages/nova/virt/libvirt/driver.py", line 2756, in spawn 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] destroy_disks_on_failure=True) 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] File "/usr/lib/python2.7/site-packages/nova/virt/libvirt/driver.py", line 5195, in _create_domain_and_network 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] raise exception.VirtualInterfaceCreateException() 2018-02-06 03:50:06.496 3777 ERROR nova.compute.manager [instance: 43d61b38-658f-4752-bdb9-3da7aa2e2806] VirtualInterfaceCreateException: Virtual Interface creation failed |

setelah di lihat dari errornya, ternayata masalahnya karena “Failed to allocate the network(s), not rescheduling.” itu menyebabkan virtual port dari instance ke host compute tidak terbentuk, sehingga muncul error seperti itu. untuk mengatasi masalah tersebut sebernarnya caranya cukup simple dan mudah untuk dijalankan (ya iyalah namanya juga simple :P, becanda :D).

[Topologi]

|

1 2 3 4 5 6 7 |

-------------- ------------- | controller | ------------------------>| compute01 | -------------- ------------- | | ------------- ------------------------------->| compute02 | ------------- |

jadi saya punya 1 controller dan 2 compute

edit pada semua node (controller dan kedua compute)

|

1 2 3 4 |

[root@controller ~(keystone_admin)]# vim /etc/nova/nova.conf vif_plugging_is_fatal = False vif_plugging_timeout = 0 |

ubah nilainya seperti diatas, kalo udah tingal restart servicenya aja pada semua node

|

1 2 |

[root@controller ~(keystone_admin)]# systemctl restart openstack-nova-* [root@controller ~(keystone_admin)]# systemctl status openstack-nova-* |

untuk testing, coba buat instance lagi, harusnya berhasil, kalo masih gagal coba liat log nya lagi 😀

semoga dapat membantu 😀

wassalamualaikum

sumber : http://thaiserv.blogspot.co.id/2016/08/issue-failed-to-allocate-networks-not.html

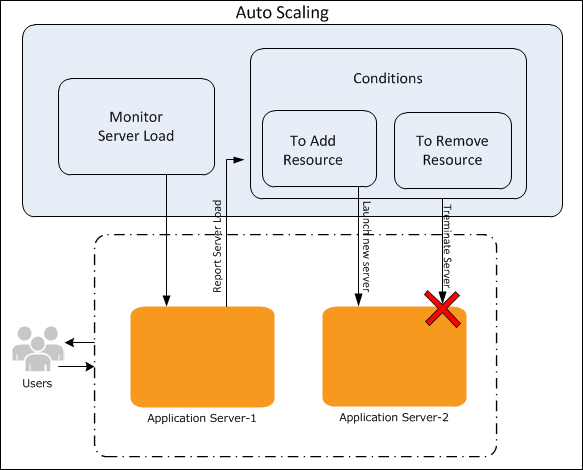

Membuat autoscaling instance pada openstack memanfaatkan layanan heat dan ceilometer

Heat autoscaling merupakan fitur tambahan pada openstack heat yang berfungsi untuk melakukan autoscaling pada sebuah mesin virtual. Komponen utama pada autoscaling adalah layanan orchestration. orchestration memungkinkan untuk mendefinisikan parameter atau aturan mengunakan template YAML yang mudah untuk dibaca. Pada aturan tersebut dapat diintegrasikan dengan layanan telemetri, sehingga ketika aturan tersebut sudah sesuai dengan aturan di layanan telemetri, maka telemetri dapat memberikan perintah ke heat orchestration untuk menambah atau mengurangi instance.

Install Openstack Ocata menggunakan Packstack

Definisi Packstack

Packstack is a utility that uses Puppet modules to deploy various parts of OpenStack on multiple pre-installed servers over SSH automatically. Currently only CentOS, Red Hat Enterprise Linux (RHEL) and compatible derivatives of both are supported (https://wiki.openstack.org/wiki/Packstack)

pada tutorial kali ini saya akan menginstall openstack versi ocata mengunakan tool deployment PackStack. packstack salah satu tool yang cukup simple untuk deploy openstack. namun kali ini saya akan membuat script bash untuk proses installasinya, supaya lebih cepet dan tidak mengulangi pekerjaan yang sama secara berulangkali jadi saya mencoba unutk membuat tool script automation.

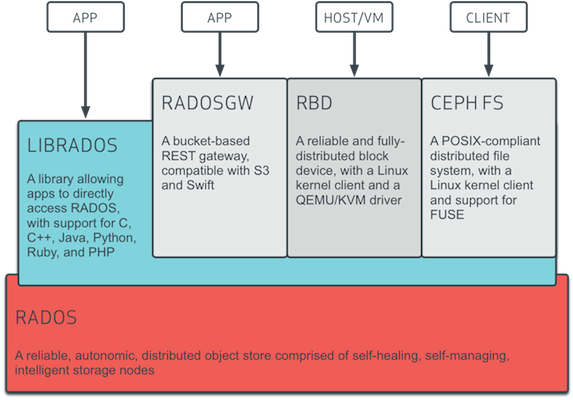

Membuat Hyper Converged Infrastructure (HCI) dengan Ceph Storage Cluster dan Proxmox 5.1

Hyperconverged Infrastructure sangat berguna untuk deployment dimana permintaan infrastruktur yang tinggi namun memiliki anggaran keuangan yang tidak terlalu besar.

HCI memberikan keuntungan sebagai berikut:

- Scalability

- Low Cost

- Data protection dan efficiency

- Simplicity

- Opensource

Ceph is a distributed object store and file system designed to provide excellent performance, reliability and scalability – http://ceph.com.

Membuat cluster di proxmox 5.1

Cluster pada proxmox dibutuhkan ketika kita sudah memiliki lebih dari satu mesin fisik proxmox, sehingga perlu dilakukan cluster untuk mempermudah dalam memanagement semua node proxmox, dalam satu dashboard.

Kelebihaan Cluster

- management terpusat mengunakan web base

- multi master cluster, dimana setiap node, dapat memanage cluster

- pmxcfs: datebase-driven file system untuk store file konfigurasi, replikasi secara real time pada semua node mengunakan corosync

- mudah dalam migrasi mesin virtual dan container antar host pve

- cepat dalam deployment

- cluster-wide service seperti firewall dan HA

Requirements Cluster

- semua node harus mengunakan network yang sama, karena corosync mengunakan IP multicast utnuk komunikasi antar node. Corosync mengunakan port UDP 5404 dan 5405 untuk komunikasi cluster (bebrapa switch tidak support ip multicast by defaultnya dan harus di aktifkan secara manual)

- Tanggal dan waktu harus sinkron

- ssh tunnel mengunakan port tcp 22

- jika tertarik lebih kearah HA, maka butuh minimal 3 node untuk diaktifkan quorumnya. Semua node harus memiliki versi yang sama

- untuk rekomendasi membutuhkan dedicated NIC untuk traffik cluster, lebih khusus lagi jika mengunakan share storage

Komentar