Hyperconverged Infrastructure sangat berguna untuk deployment dimana permintaan infrastruktur yang tinggi namun memiliki anggaran keuangan yang tidak terlalu besar.

HCI memberikan keuntungan sebagai berikut:

- Scalability

- Low Cost

- Data protection dan efficiency

- Simplicity

- Opensource

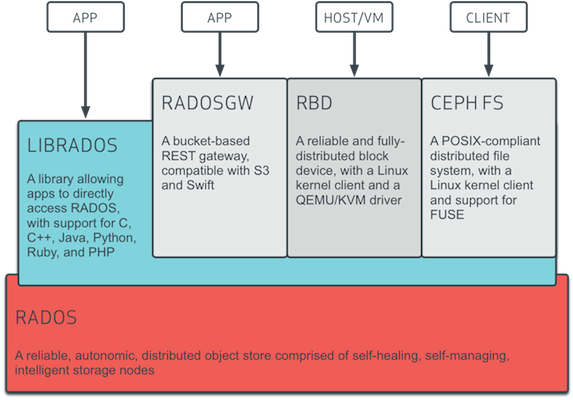

Ceph is a distributed object store and file system designed to provide excellent performance, reliability and scalability – http://ceph.com.

Proxmox Ve mendukung Ceph RADOS Block Device yang akan digunakan untuk VM dan disk container. Untuk deployment yang lebih kecil, itu sangat memungkinkan untuk menginstall ceph pada pve host.

Keuntungan Ceph

- Mudah untuk disetup dan management dengan dukungan cli atau gui pada proxmox VE

- Thin provisioning

- Mendukung Snapshots

- No single point of failure

- Self healing

- Scalable ke tingkat exabyte

- Setup pool dengan karakteristik kinerja dan redundansi yang berbeda

- Data direplikasi, sehingga bisa fault tolerant

- Dapat berjalan pada perangkat keras yang ekonomis

- Tidak perlu RAID controller

- Management yang mudah

- Opensource

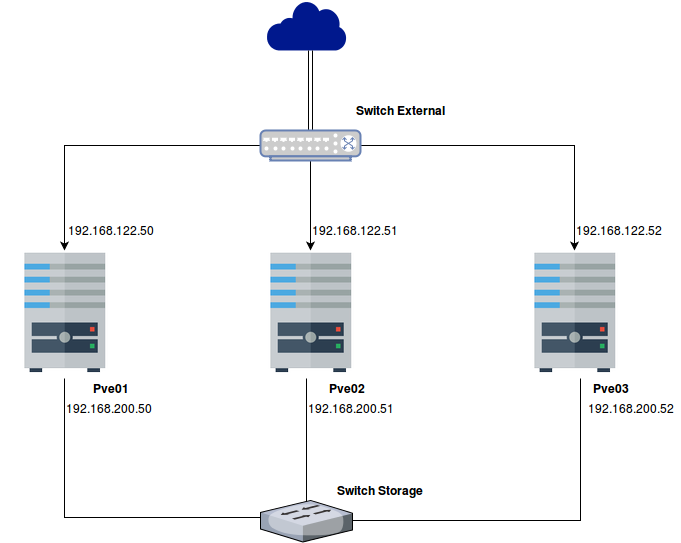

Topologi Lab

sebelumnya kita harus setting cluster proxmox terlebih dahulu disini , setelah itu setting networknya untuk storage

sebelumnya kita harus setting cluster proxmox terlebih dahulu disini , setelah itu setting networknya untuk storage

Network for ceph cluster storage

Pve01

|

1 2 3 4 |

auto ens8 iface ens8 inet static address 192.168.200.50 netmask 255.255.255.0 |

Pve02

|

1 2 3 4 |

auto ens8 iface ens8 inet static address 192.168.200.51 netmask 255.255.255.0 |

Pve03

|

1 2 3 4 |

auto ens8 iface ens8 inet static address 192.168.200.52 netmask 255.255.255.0 |

Install Paket Ceph Luminous pada semua node pve

|

1 |

pveceph install --version luminous |

kemudian membuat konfigurasi initial ceph, setelah menginstal paket ceph kita perlu untuk mengkonfigurasi initial ceph hanya pada satu host pve saja, dengan network khusus storage.

|

1 |

root@pve02:~# pveceph init --network 192.168.200.0/24 |

Membuat ceph monitor pada semua node pve

Ceph Monitor berfungsi untuk memetakan file yang akan di letakan pada OSD

pve01

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 |

root@pve01:~# pveceph createmon Created symlink /etc/systemd/system/ceph-mon.target.wants/ceph-mon@pve01.service -> /lib/systemd/system/ceph-mon@.service. admin_socket: exception getting command descriptions: [Errno 2] No such file or directory INFO:ceph-create-keys:ceph-mon admin socket not ready yet. INFO:ceph-create-keys:ceph-mon is not in quorum: u'probing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'probing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'electing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'electing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'electing' INFO:ceph-create-keys:Talking to monitor... exported keyring for client.admin updated caps for client.admin INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... creating manager directory '/var/lib/ceph/mgr/ceph-pve01' creating keys for 'mgr.pve01' setting owner for directory enabling service 'ceph-mgr@pve01.service' Created symlink /etc/systemd/system/ceph-mgr.target.wants/ceph-mgr@pve01.service -> /lib/systemd/system/ceph-mgr@.service. starting service 'ceph-mgr@pve01.service' |

pve02

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 |

root@pve02:~# pveceph createmon creating /etc/pve/priv/ceph.client.admin.keyring monmaptool: monmap file /tmp/monmap monmaptool: generated fsid 1ea91ba0-da0b-4a4c-b469-78f6888c5f65 epoch 0 fsid 1ea91ba0-da0b-4a4c-b469-78f6888c5f65 last_changed 2017-10-26 16:57:27.838912 created 2017-10-26 16:57:27.838912 0: 192.168.200.51:6789/0 mon.pve02 monmaptool: writing epoch 0 to /tmp/monmap (1 monitors) Created symlink /etc/systemd/system/ceph-mon.target.wants/ceph-mon@pve02.service -> /lib/systemd/system/ceph-mon@.service. admin_socket: exception getting command descriptions: [Errno 2] No such file or directory INFO:ceph-create-keys:ceph-mon admin socket not ready yet. INFO:ceph-create-keys:Key exists already: /etc/ceph/ceph.client.admin.keyring INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... creating manager directory '/var/lib/ceph/mgr/ceph-pve02' creating keys for 'mgr.pve02' setting owner for directory enabling service 'ceph-mgr@pve02.service' Created symlink /etc/systemd/system/ceph-mgr.target.wants/ceph-mgr@pve02.service -> /lib/systemd/system/ceph-mgr@.service. starting service 'ceph-mgr@pve02.service |

pve03

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 |

root@pve03:~# pveceph createmon Created symlink /etc/systemd/system/ceph-mon.target.wants/ceph-mon@pve03.service -> /lib/systemd/system/ceph-mon@.service. INFO:ceph-create-keys:ceph-mon is not in quorum: u'probing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'probing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'electing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'electing' INFO:ceph-create-keys:ceph-mon is not in quorum: u'electing' INFO:ceph-create-keys:Talking to monitor... exported keyring for client.admin updated caps for client.admin INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... INFO:ceph-create-keys:Talking to monitor... creating manager directory '/var/lib/ceph/mgr/ceph-pve03' creating keys for 'mgr.pve03' setting owner for directory enabling service 'ceph-mgr@pve03.service' Created symlink /etc/systemd/system/ceph-mgr.target.wants/ceph-mgr@pve03.service -> /lib/systemd/system/ceph-mgr@.service. starting service 'ceph-mgr@pve03.service' |

Membuat Ceph OSD

OSD (Object Storage Daemon) berfungsi untuk menyimpan virtual disk vm dan container. Untuk define awal osd harus hati-hati karena akan menghapus semua data pada disk yang didaftarkan sebagai osd.

Pve01

|

1 2 3 |

root@pve01:~# pveceph createosd /dev/sdb root@pve01:~# pveceph createosd /dev/vda root@pve01:~# partprobe |

pve02

|

1 2 3 |

root@pve01:~# pveceph createosd /dev/sdb root@pve01:~# pveceph createosd /dev/vda root@pve01:~# partprobe |

pve03

|

1 2 3 |

root@pve01:~# pveceph createosd /dev/sdb root@pve01:~# pveceph createosd /dev/vda root@pve01:~# partprobe |

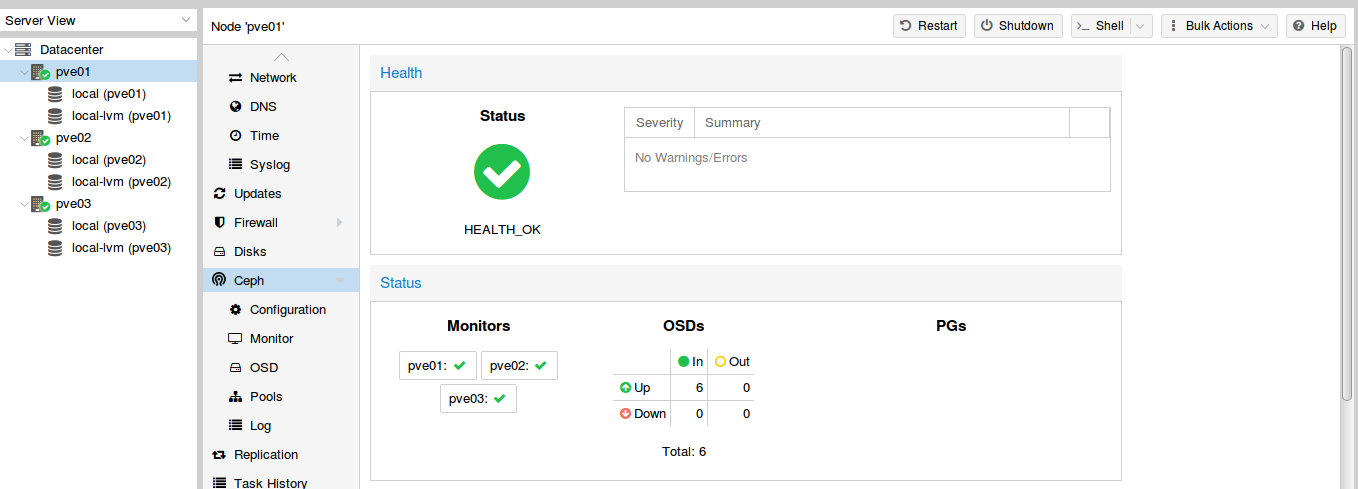

dashboard ceph di proxmox

setelah itu setting keyring ceph pada semua node pve

|

1 2 3 |

# mkdir /etc/pve/priv/ceph # cp /etc/pve/priv/ceph.client.admin.keyring /etc/pve/priv/ceph/ceph-vm.keyring # cp /etc/pve/priv/ceph.client.admin.keyring /etc/pve/priv/ceph/ceph-lxc.keyring |

kemudian buat pool storage

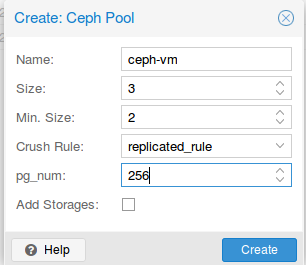

Pve01 => Ceph => Pools => Create (ceph-vm => untuk image vm)

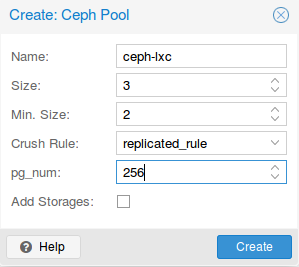

Pve01 => Ceph => Pools => Create (ceph-lxc => untuk contrainer)

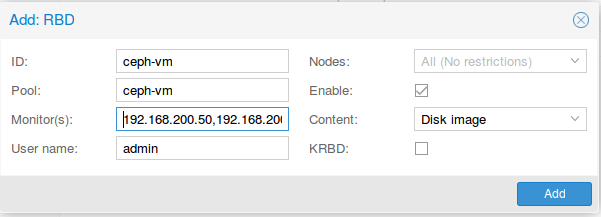

Setelah itu tambahkan storage untuk vm ke pool yang sudah di buat

Datacenter => Storage => Add => RBD (external) * (monitor = 192.168.200.50,192.168.200.51,192.168.200.52)

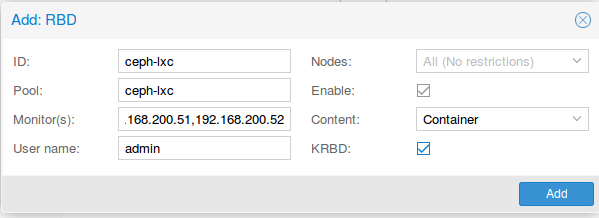

Setelah itu tambahkan storage untuk lxc ke pool yang sudah di buat

Datacenter => Storage => Add => RBD (external) * (monitor = 192.168.200.50,192.168.200.51,192.168.200.52)

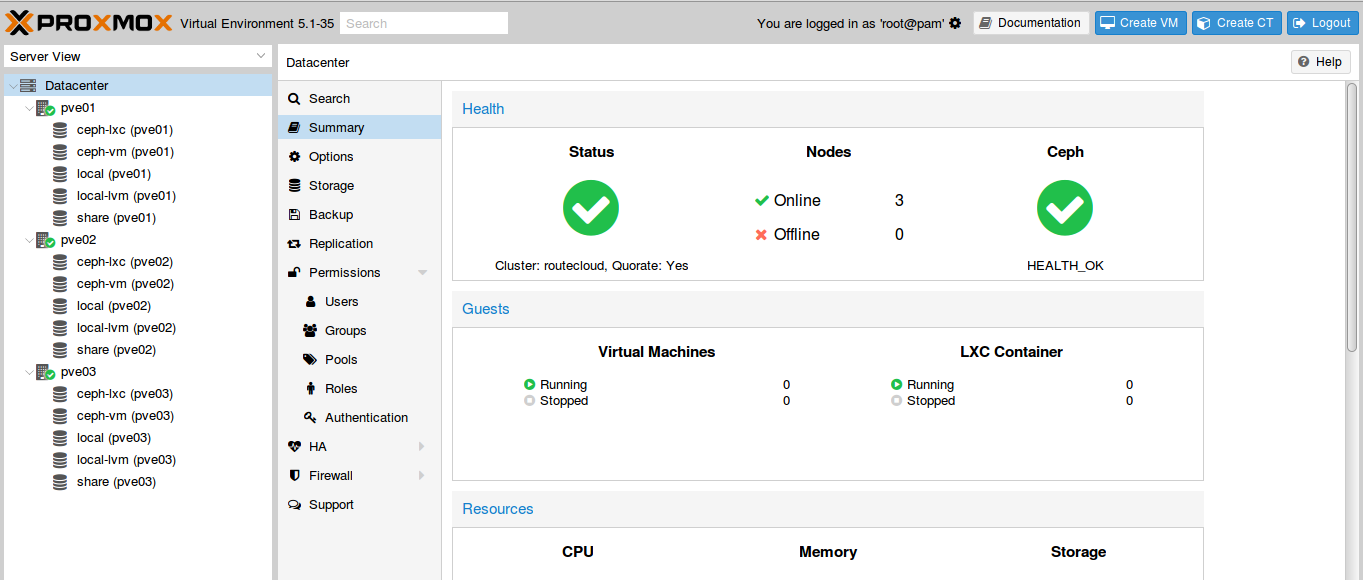

Tampilan dashboard, ketika sudah tambahkan storage RBD

Tampilan dashboard, ketika sudah tambahkan storage RBD

Komentar